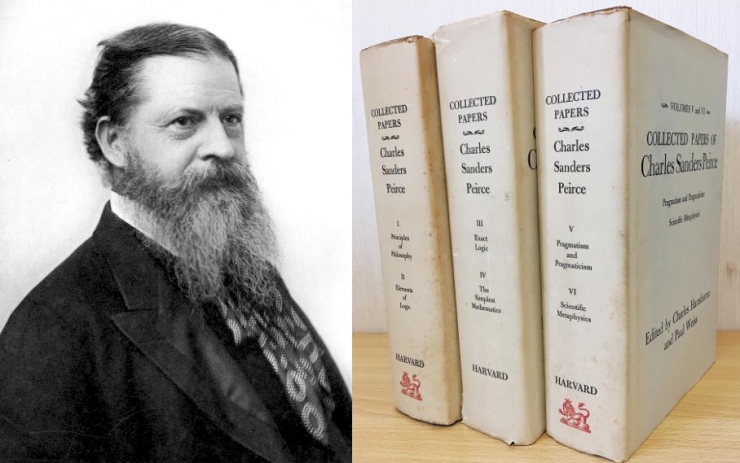

A fines del siglo XIX el semiofilósofo Charles S. Peirce (cada vez que alguien escribe «Pierce» muere el ícono de un gatito) desarrolló un marco para comprender el razonamiento humano basado en la lógica formal. Tres tipos bien conocidos de razonamiento estaban en el centro de su sistema: la deducción (silogismo), la inducción y abducción.

Repasemos la primera lección de semiótica peirceana:

- Deducción (Silogismo): La deducción es un proceso de razonamiento en el que llegamos a una conclusión específica a partir de premisas generales o conocimientos previos. Utiliza un patrón lógico en el que si las premisas son verdaderas, la conclusión también debe ser verdadera. Un ejemplo clásico sería:

- Premisa 1: Todos los humanos son mortales.

- Premisa 2: Platón es humano.

- Conclusión: Por lo tanto, Platón es mortal.

(Sí, esta vez decidí salvar a Sócrates).

La deducción sigue una estructura rigurosa y se basa en reglas lógicas.

- Inducción: La inducción es un proceso de razonamiento en el que se infiere una generalización o patrón a partir de observaciones o datos específicos. A diferencia de la deducción, la conclusión en la inducción no es necesariamente cierta, sino que se basa en una probabilidad. Un ejemplo sencillo sería:

- Observación 1: Cada cuervo que he visto es negro.

- Observación 2: Otro cuervo que veo es negro.

- Conclusión probable: Es probable que todos los cuervos sean negros.

La inducción implica hacer suposiciones basadas en la información disponible, pero no garantiza la verdad absoluta de la conclusión.

- Abducción: La abducción es un proceso de razonamiento en el que se propone una explicación plausible para un fenómeno o situación dada. En lugar de derivar una conclusión como en la deducción, o generalizar como en la inducción, la abducción busca encontrar la mejor explicación posible para algo. Es un tipo de razonamiento inferencial que se utiliza cuando se enfrenta a situaciones desconocidas o ambiguas. Un ejemplo podría ser:

- Situación: Encuentras un suelo mojado y charcos en el suelo.

- Explicación abductiva: Es probable que haya llovido recientemente.

La abducción implica generar hipótesis o conjeturas que se ajusten a los datos observados, sin necesariamente garantizar su certeza.

Con estos tres conceptos en la mochila podemos internarnos en el mundo de las inteligencias artificiales (en plural, como corresponde).

Evolución de las IA

La evolución de las inteligencias artificiales estuvo marcada por una secuencia de paradigmas, esperanzas («primaveras») y fracasos («inviernos») desde mediados del siglo XX. Es una historia muy rica que conviene repasar antes de entrar en estos temas. A continuación un breve resumen -sencillito y construido con grandes pinceladas- de esa historia.

En las décadas de 1950 y 1960, las inteligencias artificiales comenzaron a tomar forma como un campo de investigación autónomo. Alan Turing sentó las bases para evaluar la inteligencia de las máquinas con su famoso Test de Turing, que planteaba la pregunta de si una máquina podría exhibir un comportamiento inteligente indistinguible del humano. En 1956, John McCarthy acuñó el término «inteligencia artificial» y organizó la mítica Conferencia de Dartmouth, que reunió a investigadores de diversos campos para discutir y explorar la idea de crear máquinas inteligentes. Durante esta fase se desarrollaron los primeros programas de inteligencia artificial, los cuales se propusieron resolver problemas mediante el razonamiento lógico deductivo.

Estos primeros sistemas de inteligencia artificial eran llamados «simbólicos» porque utilizaban reglas lógicas y símbolos para representar y razonar sobre el conocimiento, imitando el pensamiento humano a través de reglas y relaciones entre conceptos. Estos sistemas llegaron ser eficaces en dominios específicos con reglas bien definidas (por ejemplo, para jugar al ajedrez), pero pueden quedarse perplejos frente a la comprensión de la ambigüedad y la adaptación a situaciones complejas.

Estas limitaciones llevaron a una de las primeras crisis de la investigación en inteligencia artificial. Como explica Eric Larson en The Myth of Artificial Intelligence (2021),

After the failure of what critics dubbed “good old-fashioned artificial intelligence,” which dominated AI before the modern era (up through the 1990s), AI scientists abandoned deductive approaches to inference en masse. Indeed, many younger readers might find it strange that something like “rules” and deductive approaches to AI were ever taken seriously by practitioners in the field (p. 115).

Ante estas limitaciones, la comunidad científica comenzó a explorar otros recorridos, desde las redes neuronales (el llamado «conexionismo«) hasta el uso masivo de datos para que las máquinas aprendieran a realizar ciertas tareras (también conocido como «aprendizaje automático» o machine learning). Los sistemas «semisimbólicos» presentan una combinación de enfoques simbólicos y de aprendizaje automático. Al igual que los simbólicos, este tipo de sistema utiliza reglas lógicas y símbolos, pero también integra técnicas de aprendizaje automático para procesar grandes cantidades de datos y mejorar su capacidad de adaptación a situaciones más complejas y cambiantes (por ejemplo, el tráfico de vehículos o el comportamiento de los mercados financieros). La combinación de razonamiento lógico y análisis de datos permite abordar problemas que requieren tanto conocimiento explícito como la capacidad de aprender patrones a partir de ejemplos. A partir de la década de 2010, el «aprendizaje profundo» (deep learning), una variante de las redes neuronales profundas, revolucionó las inteligencias artificiales al lograr avances significativos en áreas como el procesamiento y la creación de imágenes (buenos días, DALL·E y Midjourney) y el procesamiento del lenguaje natural (buenas tardes, ChatGPT).

Este es el reino de la inducción peirceana. Todos estos sistemas que acabo de mencionar se basan en el procesamiento de interminables bases de datos (números, textos, fotos, músicas), la identificación de patrones y la predicción de «lo que sigue». Podríamos decir que todas estas inteligencias artificiales se focalizan en las series que se repiten más a menudo y dejan de lado los datos o relaciones menos comunes, marginales o periféricos. En otras palabras: de frente a una masa de datos y relaciones, las inteligencias artificiales basadas en el machine learning y el deep learning se concentran en analizar y procesar la parte más densa y alta de la curva (verde) mientras tienden a olvidarse de la long tail (amarilla).

Según Larson

statistical AI ends up with a long-tail problem, where common patterns (in the fat head of a distribution curve) are easy, but rare ones (in the long tail) are hard. Unfortunately, some inferences made by humanly intelligent AI systems will be in the long tail, not in the sweet spot of induction from discoverable regularities in closed-world systems (p. 128).

Una parte importante de los sesgos que demuestran las inteligencias artificiales provienen de esta lógica inductiva de funcionamiento.

En búsqueda de la abducción perdida

Tanto los modelos simbólicos como los basados en el machine learning y el deep learning son buenos para ciertas cosas pero ni de lejos se acercan a la flexibilidad y creatividad de la mente humana. ¿Qué le falta a las inteligencias artificiales para funcionar de una manera al menos cercana a la del Homo sapiens? Desde los semióticos hasta los ingenieros, pasando por los expertos en ciencias cognitivas y psicología consideran que la respuesta está en la abducción de Charles S. Peirce. Si la inducción avanza de los hechos específicos a las generalizaciones, brindándonos el conocimiento de regularidades, la abducción pasa de observar hechos particulares a formular reglas o hipótesis que los expliquen. Ya sea que la llamemos sentido común (como Sherlock Holmes) o instinto (como hizo Charles S. Peirce), la abducción parece ser el punto de partida para cualquier pensamiento inteligente. Según Larson la inteligencia artificial carece de una teoría fundamental: una teoría de la inferencia abductiva (p. 189).

Since the three known types of inference are not reducible to each other but are distinct, and abductive inference is required for general intelligence, purely inductively inspired techniques like machine learning remain inadequate, no matter how fast computers get (…) In open-ended scenarios requiring knowledge about the world like language understanding, abduction is central and irreplaceable (p. 231).

La referencia al detective de Baker Street no es casual. Para Larson

abduction captures the insight that much of our everyday reasoning is a kind of detective work, where we see facts (data) as clues to help us make sense of things (p. 161).

Es probable que si Peirce hubiera sabido acerca de las inteligencias artificiales, fantasea Larson, habría visto lo que hoy en día se pasa por alto con demasiada frecuencia: que el problema de la inferencia abductiva es el gran desafío y misterio sin resolver de las inteligencias artificiales (p. 99).

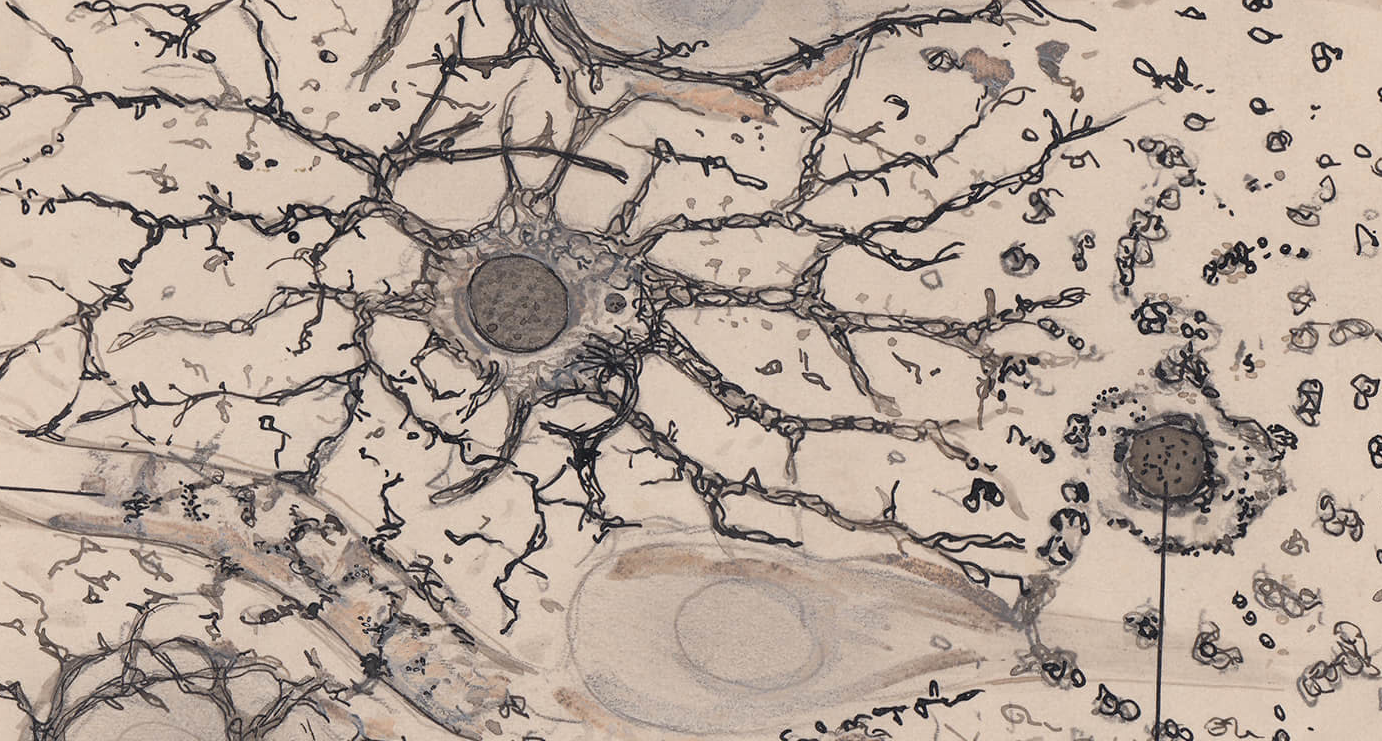

La gran máquina abductiva

Para semióticos como Stéphanie Walsh Matthews y Marcel Danesi «es poco probable que la IA pase alguna vez una prueba de abducción, ya que las inferencias son impredecibles y se basan en experiencias corporales» (AI: A Semiotic Perspective, 2019, p. 210). ¿Quién lo hubiera dicho? Muchas limitaciones de los sistemas de inteligencia artificial contemporáneos tienen una raíz lógica-semiótica y radican en la dificultad que demuestran a la hora de reproducir las operaciones de la máquina abductiva más compleja jamás construida: el cerebro humano. Mientras tanto, tenemos que conformarnos con poderosas máquinas inductivas basadas en el big data y el poder de procesamiento cada vez mayor de nuestras computadoras.

Bonus tracks

Existe una traducción al castellano del libro de Eric Larson: El mito de la inteligencia artificial, Shackleton Books, 2022.

«The Problem of Induction and Machine Learning» por Vaden Masrani.

«Induction, Popper, and machine learning» por Bruce Nielson y Daniel C. Elton.

«Inteligencia artificial y sesgos algorítmicos» por Enzo Ferrante.

“Los avances actuales no nos acercan más a tener una inteligencia artificial similar a la humana» – Entrevista a Erik Larson de Carlos del Castillo.

«10 tesis sobre la IA» por C.A. Scolari.

«ChatGPT: del Test de Turing al Test de Baricco» por C.A. Scolari.

Según ChatGPT4: «el razonamiento abductivo implica un proceso creativo e impredecible que se basa en experiencias y conocimientos previos, lo cual puede ser difícil de replicar en un sistema artificial. Sin embargo, esto no significa que la IA no pueda utilizar el razonamiento abductivo en absoluto, sino que puede haber limitaciones en su capacidad para hacerlo de manera efectiva.» De hecho lo utiliza actualmente en muchos campos como el diagnóstico médico, la planificación y la toma de decisiones.

Preguntar al ChatGPT no me parece hoy por hoy la mejor forma de intercambiar ideas. Si bien se han hecho esfuerzos por incorporar la abducción a las IA, hasta ahora la bibliografía coincide en que no se ha llegado a los resultados previstos. El libro de Larson menciona los modelos Bayesianos, pero dice que solo terminaron produciendo una inducción disfrazada de abducción (ver esta síntesis del libro y entrevista: https://venturebeat.com/ai/abductive-inference-is-a-major-blind-spot-for-ai/). De todas maneras, todo va tan rápido y hay tanto capital y expectativas que quizás las cosas cambien en breve… o no.